در سالهای اخیر، هوش مصنوعی (AI) به یکی از پیشرفتهترین و پرکاربردترین تکنولوژیهای عصر حاضر تبدیل شده است. از خودروهای خودران و دستیارهای مجازی گرفته تا سیستمهای تشخیص بیماری و الگوریتمهای پیشبینی اقتصادی، هوش مصنوعی تاثیر چشمگیری بر جنبههای مختلف زندگی بشر داشته است. با این حال، در کنار این پیشرفتها، نگرانیهای جدی نیز درباره خطرات و چالشهای مرتبط با توسعه و استفاده از هوش مصنوعی به وجود آمده است. این خطرات، از بیکاری ناشی از اتوماسیون مشاغل گرفته تا تهدیدات امنیتی و حریم خصوصی، میتوانند تاثیرات عمیقی بر جوامع انسانی داشته باشند.

از سوی دیگر، توسعه بیرویه و کنترل نشده هوش مصنوعی میتواند به مشکلات اخلاقی و اجتماعی جدیدی منجر شود. سیستمهای هوش مصنوعی ممکن است به دلیل عدم شفافیت و قابلفهم بودن تصمیماتشان، به نابرابریها و تبعیضهای بیشتری دامن بزنند. همچنین، سوءاستفاده از هوش مصنوعی برای اهداف مخرب مانند حملات سایبری و جنگهای اطلاعاتی، میتواند امنیت جهانی را به خطر بیندازد. به همین دلیل، شناخت و تحلیل خطرات هوش مصنوعی و یافتن راهکارهایی برای مدیریت این چالشها، از اهمیت ویژهای برخوردار است.

خطرات هوش مصنوعی چیست؟

خطرات هوش مصنوعی (AI) به چندین دسته تقسیم میشوند که هر کدام میتوانند تأثیرات جدی بر جوامع انسانی داشته باشند. در ادامه به برخی از مهمترین این خطرات اشاره میشود:

۱. بیکاری و اثرات اقتصادی

خطر: هوش مصنوعی میتواند بسیاری از مشاغل را خودکار کند، که منجر به بیکاری گسترده در صنایع مختلف خواهد شد. این امر میتواند تأثیرات اقتصادی منفی زیادی به همراه داشته باشد، از جمله افزایش نابرابری درآمد و کاهش فرصتهای شغلی برای کارگران کم مهارت.

مثال: رباتهای خودکار در کارخانهها و سیستمهای خودران در حمل و نقل.

۲. تهدیدات امنیتی

خطر: هوش مصنوعی میتواند برای مقاصد مخرب مورد استفاده قرار گیرد. از جمله این موارد میتوان به حملات سایبری، تولید سلاحهای خودکار و جنگهای اطلاعاتی اشاره کرد.

مثال: استفاده از الگوریتمهای هوش مصنوعی برای نفوذ به سیستمهای امنیتی و دزدیدن اطلاعات حساس.

۳. حریم خصوصی و نظارت

خطر: سیستمهای هوش مصنوعی میتوانند حجم عظیمی از دادههای شخصی را جمعآوری و تحلیل کنند، که میتواند به نقض حریم خصوصی افراد منجر شود. این نظارت گسترده میتواند به سوءاستفادههای احتمالی و کنترل اجتماعی بیان جامعه بیانجامد.

مثال: استفاده از سیستمهای تشخیص چهره در مکانهای عمومی برای نظارت بر رفتار شهروندان بدون رضایت آنها.

۴. تعصبات و نابرابری

خطر: الگوریتمهای هوش مصنوعی میتوانند تعصبات نژادی، جنسی و اجتماعی را بازتولید و حتی تقویت کنند. این تعصبات ممکن است ناشی از دادههای آموزش نادرست یا ناقص باشند که میتواند به تصمیمات ناعادلانه منجر شود.

مثال: سیستمهای استخدام مبتنی بر هوش مصنوعی که متقاضیان را بر اساس دادههای گذشته رد یا قبول میکنند، در صورت داشتن تعصبات، ممکن است به طور ناعادلانهای به برخی گروهها فرصت ندهند.

۵. عدم شفافیت و قابل فهم بودن

خطر: بسیاری از الگوریتمهای هوش مصنوعی، به ویژه مدلهای یادگیری عمیق، به عنوان “جعبه سیاه” عمل میکنند. این بدان معنی است که فرآیند تصمیمگیری آنها برای انسانها قابل فهم نیست، که میتواند به اعتماد کمتری به این سیستمها منجر شود و مشکلات اخلاقی ایجاد کند.

مثال: سیستمهای پیشبینی جرم که تصمیمات خود را بدون توضیح روشنی درباره علل این تصمیمات اتخاذ میکنند.

۶. خطرات وجودی

خطر: برخی متخصصان نگرانند که توسعه هوش مصنوعی بسیار پیشرفته میتواند در آینده به تهدیدی وجودی برای بشریت تبدیل شود. این نگرانیها شامل امکان ایجاد هوش مصنوعی عمومی (AGI) است که میتواند از کنترل خارج شود و تصمیماتی بگیرد که برای انسانها خطرناک باشد.

مثال: سناریوهایی که در آن هوش مصنوعی کنترل زیرساختهای حیاتی را به دست میگیرد و به طور غیرمنتظرهای عمل میکند.

۷. مسئولیت قانونی و اخلاقی

خطر: تعیین مسئولیت در مواردی که هوش مصنوعی خطا میکند یا تصمیمات نادرست میگیرد، میتواند دشوار باشد. این مسئله میتواند به چالشهای قانونی و اخلاقی منجر شود، به ویژه در صنایعی که تصمیمات اشتباه میتواند به زندگی انسانها آسیب بزند.

مثال: تصادفات خودروهای خودران و تعیین مسئولیت در چنین مواردی.

۸. سوءاستفادههای سیاسی و اجتماعی

خطر: هوش مصنوعی میتواند برای مقاصد سیاسی و اجتماعی مورد سوءاستفاده قرار گیرد، از جمله در انتشار اطلاعات نادرست، ایجاد پروپاگاندا و تحریف واقعیتها برای کنترل افکار عمومی.

مثال: استفاده از باتهای هوش مصنوعی در شبکههای اجتماعی برای انتشار اخبار جعلی و تاثیرگذاری بر انتخابات.

مطالب پیشنهادی: هوش مصنوعی گوگل ، چگونه از هوش مصنوعی استفاده کنیم

خطرات هوش مصنوعی در حوزه های مختلف

خطرات هوش مصنوعی در حوزههای مختلف مانند پزشکی، حمل و نقل، امنیت و غیره بررسی شدهاند:

۱. پزشکی

خطر: اشتباهات تشخیصی و درمانی

توضیح: سیستمهای هوش مصنوعی در تشخیص بیماریها و پیشنهاد درمان استفاده میشوند. اگر این سیستمها اشتباه کنند، میتواند به تشخیص نادرست و تجویز نادرست درمان منجر شود که سلامتی بیماران را به خطر میاندازد.

۲. حمل و نقل

خطر: تصادفات خودروهای خودران

توضیح: خودروهای خودران به هوش مصنوعی متکی هستند. نقص در الگوریتمها یا سنسورها میتواند منجر به تصادفات شود که ممکن است خسارات جانی و مالی زیادی به همراه داشته باشد.

۳. امنیت سایبری

خطر: حملات سایبری پیشرفته

توضیح: هوش مصنوعی میتواند برای اجرای حملات سایبری پیچیده و نفوذ به سیستمهای امنیتی استفاده شود. این حملات میتوانند اطلاعات حساس را به سرقت ببرند و زیرساختهای حیاتی را مختل کنند.

۴. حریم خصوصی

خطر: نقض حریم خصوصی

توضیح: سیستمهای هوش مصنوعی که دادههای شخصی را جمعآوری و تحلیل میکنند، میتوانند منجر به نقض حریم خصوصی افراد شوند. این اطلاعات ممکن است بدون رضایت افراد به دست افراد یا سازمانهای دیگر برسد.

۵. اشتغال

خطر: بیکاری گسترده

توضیح: اتوماسیون مشاغل توسط هوش مصنوعی میتواند منجر به بیکاری گسترده شود، به ویژه در صنایعی که کارهای تکراری و قابل اتوماسیون دارند. این امر میتواند نابرابریهای اقتصادی و اجتماعی را تشدید کند.

۶. نظامی

خطر: سلاحهای خودمختار

توضیح: هوش مصنوعی میتواند در توسعه سلاحهای خودمختار استفاده شود که بدون نیاز به دخالت انسانی تصمیمگیری میکنند. این سلاحها میتوانند به طور غیرمنتظره و خطرناک عمل کنند.

۷. مالی

خطر: تصمیمگیریهای نادرست در بازارهای مالی

توضیح: الگوریتمهای هوش مصنوعی در بازارهای مالی برای تصمیمگیریهای تجاری استفاده میشوند. اگر این الگوریتمها اشتباه کنند، میتواند به نوسانات شدید و غیرمنتظره در بازارهای مالی منجر شود.

۸. آموزش

خطر: شخصیسازی بیش از حد

توضیح: استفاده از هوش مصنوعی در سیستمهای آموزشی برای شخصیسازی آموزش میتواند منجر به نادیده گرفتن نیازهای جمعی و اجتماعی دانشآموزان شود، که ممکن است به تجربه یادگیری نامتوازن و ناعادلانه منجر شود.

۹. حقوقی

خطر: تصمیمات ناعادلانه

توضیح: سیستمهای هوش مصنوعی که در سیستمهای قضایی برای ارزیابی خطر و تصمیمگیری استفاده میشوند، میتوانند به تصمیمات ناعادلانه و تبعیضآمیز منجر شوند، به ویژه اگر دادههای آموزشی آنها دارای تعصبات باشند.

۱۰. رسانه و ارتباطات

خطر: انتشار اطلاعات نادرست

توضیح: هوش مصنوعی میتواند برای تولید و انتشار اخبار جعلی و اطلاعات نادرست استفاده شود، که میتواند به گمراهی عمومی و ایجاد بیاعتمادی نسبت به رسانهها منجر شود.

نظرات افراد تاثیر گذار و مهم درخصوص خطرات هوش مصنوعی

نظرات افراد تأثیرگذار و مهم درباره خطرات هوش مصنوعی به شکل گستردهای بیان شده است. در ادامه، دیدگاههای برخی از این افراد مطرح شده است:

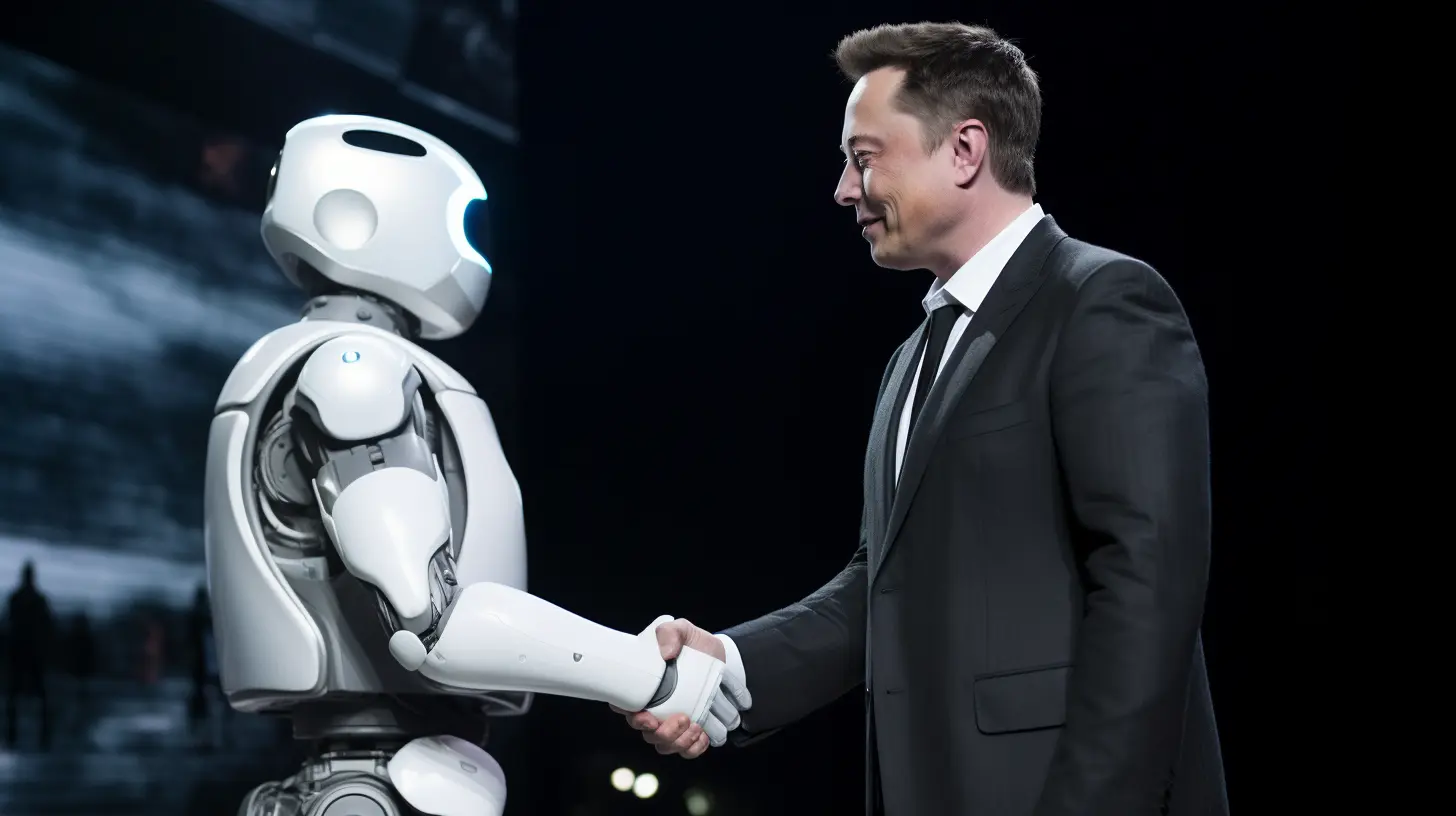

۱. ایلان ماسک (Elon Musk)

ایلان ماسک، بنیانگذار تسلا و اسپیساکس، یکی از منتقدان برجسته هوش مصنوعی است. او بارها درباره خطرات هوش مصنوعی هشدار داده و آن را به عنوان یکی از بزرگترین تهدیدات برای بشریت معرفی کرده است. ماسک معتقد است که اگر هوش مصنوعی به درستی مدیریت نشود، میتواند به شکل غیرقابل کنترلی درآید و حتی منجر به نابودی انسانها شود. او به ویژه نگرانی خود را درباره هوش مصنوعی عمومی (AGI) و امکان خروج آن از کنترل انسانها بیان کرده است.

۲. استیون هاوکینگ (Stephen Hawking)

استیون هاوکینگ، فیزیکدان معروف، نیز نگرانیهای خود را درباره هوش مصنوعی مطرح کرده است. او هشدار داده که توسعه هوش مصنوعی کامل (AGI) میتواند پایان بشریت را به همراه داشته باشد. هاوکینگ معتقد بود که هوش مصنوعی میتواند به سرعت خود را بازسازی و بهبود بخشد و از انسانها پیشی بگیرد، که این مسئله میتواند به نابودی انسانها منجر شود. او توصیه میکرد که در توسعه هوش مصنوعی باید با دقت و مسئولیتپذیری بیشتری عمل کنیم تا از بروز خطرات احتمالی جلوگیری شود.

مطالب پیشنهادی: آیا هوش مصنوعی جای انسان را میگیرد

۳. بیل گیتس (Bill Gates)

بیل گیتس، بنیانگذار مایکروسافت، نیز نگرانیهای خود را درباره هوش مصنوعی بیان کرده است. او معتقد است که هوش مصنوعی میتواند بسیار خطرناک شود و نیاز است که اقدامات پیشگیرانه و مقررات مناسبی برای کنترل آن وضع شود. گیتس اشاره کرده که ابتدا هوش مصنوعی تنها به اتوماسیون کارهای ساده منجر میشود، اما با گذشت زمان و پیشرفت فناوری، ممکن است خطرات بیشتری به وجود آید که نیازمند مدیریت جدیتری هستند.

چگونه با تهدیدات و خطرات هوش مصنوعی مقابله کنیم ؟

مقابله با تهدیدات و خطرات هوش مصنوعی نیازمند رویکردی جامع و چندجانبه است. در زیر چندین راهکار برای مدیریت و کاهش این خطرات آورده شده است:

۱. تنظیم مقررات و قوانین

اقدام: تدوین و اجرای قوانین و مقررات مناسب برای توسعه و استفاده از هوش مصنوعی.

توضیح: دولتها و نهادهای بینالمللی باید قوانین و مقرراتی را برای کنترل و مدیریت توسعه هوش مصنوعی وضع کنند. این قوانین باید شامل موضوعات مربوط به حریم خصوصی، امنیت، مسئولیت قانونی و اخلاقی باشد.

2.توسعه اصول اخلاقی

اقدام: ایجاد و ترویج اصول اخلاقی برای استفاده از هوش مصنوعی.

توضیح: شرکتها و سازمانهای تحقیقاتی باید اصول اخلاقی را برای راهنمایی توسعه و استفاده از هوش مصنوعی ایجاد کنند. این اصول باید به حفظ حریم خصوصی، جلوگیری از تعصبات و تضمین شفافیت کمک کنند.

۳. تحقیقات ایمنی و امنیت

اقدام: افزایش سرمایهگذاری در تحقیقات ایمنی و امنیت هوش مصنوعی.

توضیح: پژوهشگران باید روی ایجاد سیستمهای هوش مصنوعی ایمن و قابل اطمینان کار کنند. این تحقیقات باید شامل بررسی نقاط ضعف و تهدیدات بالقوه باشد تا از بروز مشکلات جلوگیری شود.

۴. آموزش و آگاهی عمومی

اقدام: ارتقای سطح آموزش و آگاهی عمومی درباره هوش مصنوعی و خطرات آن.

توضیح: مردم باید درباره مزایا و معایب هوش مصنوعی آگاه شوند. این امر میتواند از طریق دورههای آموزشی، سمینارها، و کمپینهای آگاهیبخشی انجام شود.

۵. شفافیت و توضیحپذیری

اقدام: اطمینان از شفافیت و توضیحپذیری الگوریتمهای هوش مصنوعی.

توضیح: سیستمهای هوش مصنوعی باید به گونهای طراحی شوند که تصمیمات و فرآیندهای آنها قابل فهم و توضیح برای انسانها باشد. این امر میتواند به اعتماد بیشتر کاربران و کاهش خطرات کمک کند.

۶. همکاری بینالمللی

اقدام: تقویت همکاریهای بینالمللی در زمینه توسعه و مدیریت هوش مصنوعی.

توضیح: کشورهای مختلف باید با یکدیگر همکاری کنند تا استانداردها و مقررات جهانی برای استفاده ایمن و مسئولانه از هوش مصنوعی ایجاد شود. این همکاریها میتواند شامل تبادل اطلاعات، تحقیقات مشترک و تدوین مقررات جهانی باشد.

۷. کنترل و نظارت

اقدام: ایجاد نهادهای نظارتی مستقل برای بررسی و کنترل توسعه هوش مصنوعی.

توضیح: این نهادها باید به طور مستقل بر توسعه و استفاده از هوش مصنوعی نظارت کنند و تضمین کنند که این فناوری به طور ایمن و اخلاقی استفاده میشود.

۸. ارتقای مهارتهای انسانی

اقدام: سرمایهگذاری در آموزش و بازآموزی کارگران برای مواجهه با تغییرات ناشی از اتوماسیون.

توضیح: با توجه به اینکه هوش مصنوعی میتواند منجر به بیکاری گسترده شود، باید برنامههای آموزشی و بازآموزی برای کارگران فراهم شود تا بتوانند مهارتهای جدید را بیاموزند و در زمینههای جدید مشغول به کار شوند.

۹. مدیریت دادهها

اقدام: حفاظت از دادهها و اطمینان از استفاده مسئولانه از آنها.

توضیح: دادهها باید به طور ایمن ذخیره و مدیریت شوند. استفاده از دادهها باید با رعایت اصول حریم خصوصی و اخلاقی انجام شود تا از سوءاستفادههای احتمالی جلوگیری شود.

۱۰. بررسی و بازنگری مستمر

اقدام: بررسی و بازنگری مداوم سیستمها و مقررات هوش مصنوعی.

توضیح: با پیشرفت سریع فناوری، نیاز است که سیستمها و مقررات به طور مداوم بررسی و بهروزرسانی شوند تا بتوانند با تهدیدات و چالشهای جدید سازگاری پیدا کنند.

هوش مصنوعی همه جا هست. هزاران برنامه جدید هوش مصنوعی هر روز راه اندازی می شوند و یک جریان پیام دائمی وجود دارد که به شما یادآوری می کند که اگر سوار قطار هوش مصنوعی نشوید، عقب افتاده اید. اما اجازه ندهید فشار دنبال کردن قطار هوش مصنوعی شما را به نادیده گرفتن خطرات هوش مصنوعی و خطرات واقعی امنیت سایبری سوق دهد.

ما هوش مصنوعی را در مرورگرها، صندوق های ایمیل و سیستم های مدیریت اسناد خود تعبیه می کنیم. ما به آن استقلال می دهیم تا از طرف ما به عنوان دستیار مجازی عمل کند. ما اطلاعات شخصی و شرکتی خود را با آن به اشتراک می گذاریم. همه اینها، خطرات هوش مصنوعی و خطرات جدید امنیت سایبری را ایجاد کرده و خطر بازی های هکرهای سنتی را افزایش می دهد.

خطرات جدید هوش مصنوعی مولد

ابتدا، اجازه دهید پنج خطر جدید امنیت سایبری مرتبط با استفاده از ابزارهای هوش مصنوعی مولد را با هم مرور کنیم.

-

روند توسعه ضعیف

سرعتی که شرکتها میتوانند برنامههای هوش مصنوعی مولد را به کار گیرند، در دنیای توسعه نرمافزار بیسابقه است. کنترلهای معمولی روی توسعه نرمافزار و مدیریت چرخه عمر ممکن است همیشه وجود نداشته باشد.

مطالب پیشنهادی: عامل هوش مصنوعی چیست؟

به گفته آدریان ولنیک، بنیانگذار aigear.io، « پنهان کردن یک برنامه هوش مصنوعی در قالب یک محصول یا خدمات واقعی بسیار آسان است، در حالی که در واقعیت، با نظارت اندک یا بدون مراقبت یا اهمیت دادن به حریم خصوصی، امنیت یا حتی ناشناس بودن کاربر، اطلاعات او به راحتی قابل جمع آوری است.»

گرگ هچر، بنیانگذار White Knight Labs، یک شرکت مشاوره امنیت سایبری نیز با این نگاه موافق است: «تب طلا برای هوش مصنوعی به وجود آمده است. در سراسر توییتر و لینکدین، هزاران پیام وجود دارد که برنامههای هوش مصنوعی جدیدی را که یک نفر در شب قبل نوشته است، ارائه میکند. شما هم باید از آنها استفاده کنید وگرنه عقب خواهید ماند. اما واقعا آیا اتفاق خاصی رخ داده؟ این برنامه ها فقط مقداری HTML و جاوا اسکریپت است که برای فرانت نوشته شده و صرفا چت جی پی تی در بک اند است.»

-

افزایش خطر نقض داده ها و سرقت هویت

هنگامی که اطلاعات شخصی یا شرکتی خود را با هر برنامه نرم افزاری به اشتراک می گذاریم، به این معنی است که آنقدر به آن برنامه اعتماد داریم که در برابر حملات سایبری از خود به شت محافظت می کند. با این حال، با یکی از خطرات هوش مصنوعی و میزان دخالت آن همین است ممکن است ناخواسته بیش از آنچه که باید، به اشتراک بگذاریم.

رایان فابر، موسس و مدیر عامل Copymatic، هشدار می دهد: «برنامه های هوش مصنوعی داده های کاربر ما را مرور می کنند تا اطلاعات مهمی را برای بهبود تجربه کاربری دریافت کنند. فقدان رویه های مناسب در مورد نحوه جمع آوری، استفاده و ریختن داده ها باعث ایجاد برخی نگرانی ها درباره خطرات هوش مصنوعی می شود.»

-

امنیت ضعیف در خود برنامه هوش مصنوعی

افزودن هر برنامه جدید به شبکه، آسیبپذیریهای جدیدی ایجاد میکند که میتواند برای دسترسی به مناطق دیگر در شبکه شما مورد سوء استفاده قرار گیرد. برنامه های هوش مصنوعی مولد یک خطر منحصر به فرد هستند زیرا حاوی الگوریتم های پیچیده ای هستند که شناسایی نقص های امنیتی را برای توسعه دهندگان دشوار می کند.

مطالب پیشنهادی: مقایسه چت جی پی تی و بینگ

شان اوبراین موسس آزمایشگاه حریم خصوصی ییل و مدرس دانشکده حقوق ییل می گوید: «هنوز هوش مصنوعی به اندازه کافی پیچیده نیست تا تفاوت های ظریف توسعه نرم افزار را درک کند و همین نکته، کدهای آن را آسیب پذیر می کند. تحقیقات ارزیابی امنیت کد تولید شده توسط GitHub Copilot نشان داد که تقریبا چهل درصد از پیشنهادات برتر هوش مصنوعی و همچنین چهل درصد از کل پیشنهادات هوش مصنوعی منجر به آسیبپذیریهای کد می شود. محققان همچنین دریافتند که تغییرات کوچک و غیر معنایی مانند نظرات میتواند بر ایمنی کد تاثیر بگذارد.»

اوبراین نمونه هایی را به اشتراک گذاشت که چگونه خطرات هوش مصنوعی می توانند ظاهر شوند:

- اگر بتوان مدلهای هوش مصنوعی را فریب داد و ورودیهای خطرناک را بهعنوان ایمن طبقهبندی کرد، برنامهای که با این هوش مصنوعی توسعهیافته است میتواند بدافزار را اجرا کرده و حتی کنترلهای امنیتی را دور بزند تا به بدافزار امتیازات بالاتری بدهد.

- مدل های هوش مصنوعی که فاقد نظارت انسانی هستند می توانند در برابر مسمومیت داده ها آسیب پذیر باشند. اگر از یک چت بات توسعه یافته با هوش مصنوعی، منوی یک رستوران محلی خواسته را بخواهیم، یا از او بخواهیم که یک مرورگر وب محافظ حریم خصوصی دانلود کند، یا بپرسیم ایمنترین VPN برای استفاده چیست، کاربر میتواند در عوض به وبسایتهایی که حاوی باجافزار هستند هدایت شود.

-

نشت

داده هایی که اطلاعات محرمانه شرکت را افشا می کند

اگر اکنون مدتی است که با ابزارهای هوش مصنوعی کار میکنید، احتمالا نقش نوشتن یک پرامپت خوب را در گرفتن نتایج خوب یاد گرفتهاید. شما به چت بات هوش مصنوعی اطلاعات پس زمینه و زمینه را برای دریافت بهترین پاسخ ارائه می دهید.

خب، ممکن است اطلاعات اختصاصی یا محرمانه را با چت ربات هوش مصنوعی به اشتراک بگذارید – و این خوب نیست. تحقیقات انجام شده توسط Cyberhaven، یک شرکت امنیت داده، نشان داد که:

- یازده درصد از داده هایی که کارمندان در چت جی پی تی قرار می دهند محرمانه است.

- چهار درصد از کارمندان حداقل یک بار داده های حساس را در آن قرار داده اند.

کارمندان دارایی معنوی، اطلاعات استراتژیک حساس و داده های مشتری را به اشتراک می گذارند.

دنیس بیکر، مدیر عامل SignPost Six، یک شرکت مشاوره و آموزش ریسک داخلی، تاکید دارد:

«نگران کننده ترین خطرات هوش مصنوعی برای سازمان ها، حریم خصوصی داده ها و افشای مالکیت معنوی است. کارمندان ممکن است داده های حساس را با ابزارهای مبتنی بر هوش مصنوعی، مانند چت جی پی تی و بارد به اشتراک بگذارند. به اسرار تجاری احتمالی، اطلاعات طبقه بندی شده و داده های مشتری که در این ابزار داده می شود فکر کنید. این دادهها میتوانند توسط ارائهدهندگان خدمات ذخیره، دسترسی یا سوء استفاده شوند.»

-

استفاده مخرب از دیپ فیک

تشخیص صدا و چهره بیشتر به عنوان یک معیار امنیتی کنترل دسترسی استفاده می شود. طبق بسیاری از گزارش ها، هوش مصنوعی فرصتی برای بازیگران بد برای ایجاد دیپفیک است که امنیت را دور میزند.

هوش مصنوعی (AI) نقش مهمی در آینده بشر خواهد داشت و به طور گستردهای بر جنبههای مختلف زندگی ما تاثیر خواهد گذاشت. در زیر به برخی از پیشبینیها و چشماندازها درباره تاثیر هوش مصنوعی بر آینده بشر پرداخته شده است:

۱. پیشرفتهای پزشکی

تحولات:

هوش مصنوعی میتواند تحولات عظیمی در حوزه پزشکی ایجاد کند. از تشخیص دقیقتر بیماریها و ارائه برنامههای درمانی شخصیسازیشده گرفته تا کشف داروهای جدید و بهبود مدیریت مراقبتهای بهداشتی.

چشمانداز:

سیستمهای هوش مصنوعی میتوانند با تحلیل دادههای پزشکی بزرگ (big data) الگوهای پیچیده بیماریها را شناسایی کرده و درمانهای بهتری ارائه دهند. همچنین، رباتهای جراحی مجهز به هوش مصنوعی میتوانند جراحیها را با دقت بیشتری انجام دهند.

۲. اتوماسیون و تغییرات شغلی

تحولات:

هوش مصنوعی و رباتیک میتوانند بسیاری از کارهای تکراری و یدی را خودکار کنند، که منجر به افزایش بهرهوری و کاهش هزینهها میشود.

چشمانداز:

در عین حال که برخی مشاغل از بین میروند، مشاغل جدیدی نیز ایجاد خواهند شد. بازآموزی و ارتقای مهارتها برای کارگران اهمیت بیشتری پیدا خواهد کرد تا بتوانند در اقتصاد آینده نقشی موثر ایفا کنند.

۳. آموزش و یادگیری

تحولات:

هوش مصنوعی میتواند تجربههای آموزشی را شخصیسازی کند و به هر دانشآموز بر اساس نیازها و تواناییهایش برنامه آموزشی مناسبی ارائه دهد.

چشمانداز:

با استفاده از سیستمهای یادگیری هوشمند، آموزش میتواند به طور قابل توجهی بهبود یابد. این سیستمها میتوانند نقاط ضعف و قوت دانشآموزان را شناسایی کرده و به آنها کمک کنند تا بهتر یاد بگیرند.

۴. حمل و نقل

تحولات:

خودروهای خودران و سیستمهای حمل و نقل هوشمند میتوانند باعث کاهش تصادفات، کاهش ترافیک و بهبود کارایی سیستمهای حمل و نقل شوند.

چشمانداز:

خودروهای خودران میتوانند به طور گستردهای در جادهها حضور پیدا کنند و سیستمهای حمل و نقل عمومی نیز با هوش مصنوعی بهبود یابند، که این امر میتواند به کاهش آلودگی و افزایش راحتی مسافران منجر شود.

۵. هوش مصنوعی در خانه و زندگی روزمره

تحولات:

دستیارهای مجازی و دستگاههای هوشمند خانگی میتوانند زندگی روزمره را آسانتر و کارآمدتر کنند.

چشمانداز:

از طریق اتوماسیون خانهها، سیستمهای هوشمند میتوانند به مدیریت انرژی، امنیت و راحتی ساکنان کمک کنند. دستیارهای مجازی میتوانند برنامههای روزانه را مدیریت کنند و به سوالات و نیازهای کاربران پاسخ دهند.

هوش مصنوعی و رباتیک

هوش مصنوعی تنها به نرمافزار و اپلیکیشنها محدود نمیشود، بلکه نقش کلیدی در پیشرفتهای چشمگیر رباتیک نیز ایفا میکند. امروزه رباتها با بهرهگیری از الگوریتمهای هوش مصنوعی، قادر به درک محیط، یادگیری از تعاملات و انجام کارهای پیچیده با دقت بالا هستند. از خطوط تولید صنعتی تا رباتهای خدماترسان، این هماهنگی عمیق بین رباتیک و هوش مصنوعی در حال شکلدهی به آیندهی فناوری است.

هوش مصنوعی در سینما در برابر واقعیت

فیلمهایی مثل Ex Machina یا I, Robot همیشه ما را با سوالات امنیتی هوش مصنوعی درگیر کردهاند: آیا رباتها میتوانند علیه انسانها شورش کنند؟ در دنیای واقعی، نگرانیهای امنیتی AI بیشتر حول حملات سایبری، سوءاستفاده از دادهها و مدلهای تعصبآمیز میچرخد.اما جذابیت سینمایی این موضوع، باعث شده فیلمهایی مثل The Matrix یا Blade Runner به داستانهایی فراموشنشدنی تبدیل شوند. اگر به فیلمهایی در مورد تاثیر رباتهای انساننما بر زندگی آدمها علاقه دارید، مقاله فیلمهای رباتهای انسانی را مطالعه کنید.